Por qué es tan difícil —y necesario— regular la inteligencia artificial

Desinformación, volatilidad de los mercados y mucho más: ante la necesidad de mitigar los riesgos que presenta la inteligencia artificial, los países y las regiones están trazando caminos diferentes.

Manténgase informado

Suscríbase al boletín de noticias de Knowable en español

Las poderosas capacidades de la inteligencia artificial (IA), antes consideradas una perspectiva lejana, se han convertido rápidamente en una realidad. La llegada de la IA moderna, que se basa en técnicas avanzadas de aprendizaje automático y aprendizaje profundo, ha dejado a los gobiernos luchando por ponerse al día y decidir cómo evitar una letanía de amenazas para la sociedad, como la propaganda cada vez más persuasiva, los ciberataques a infraestructuras públicas y la capacidad de alcanzar niveles de vigilancia sin precedentes por parte de gobiernos y empresas.

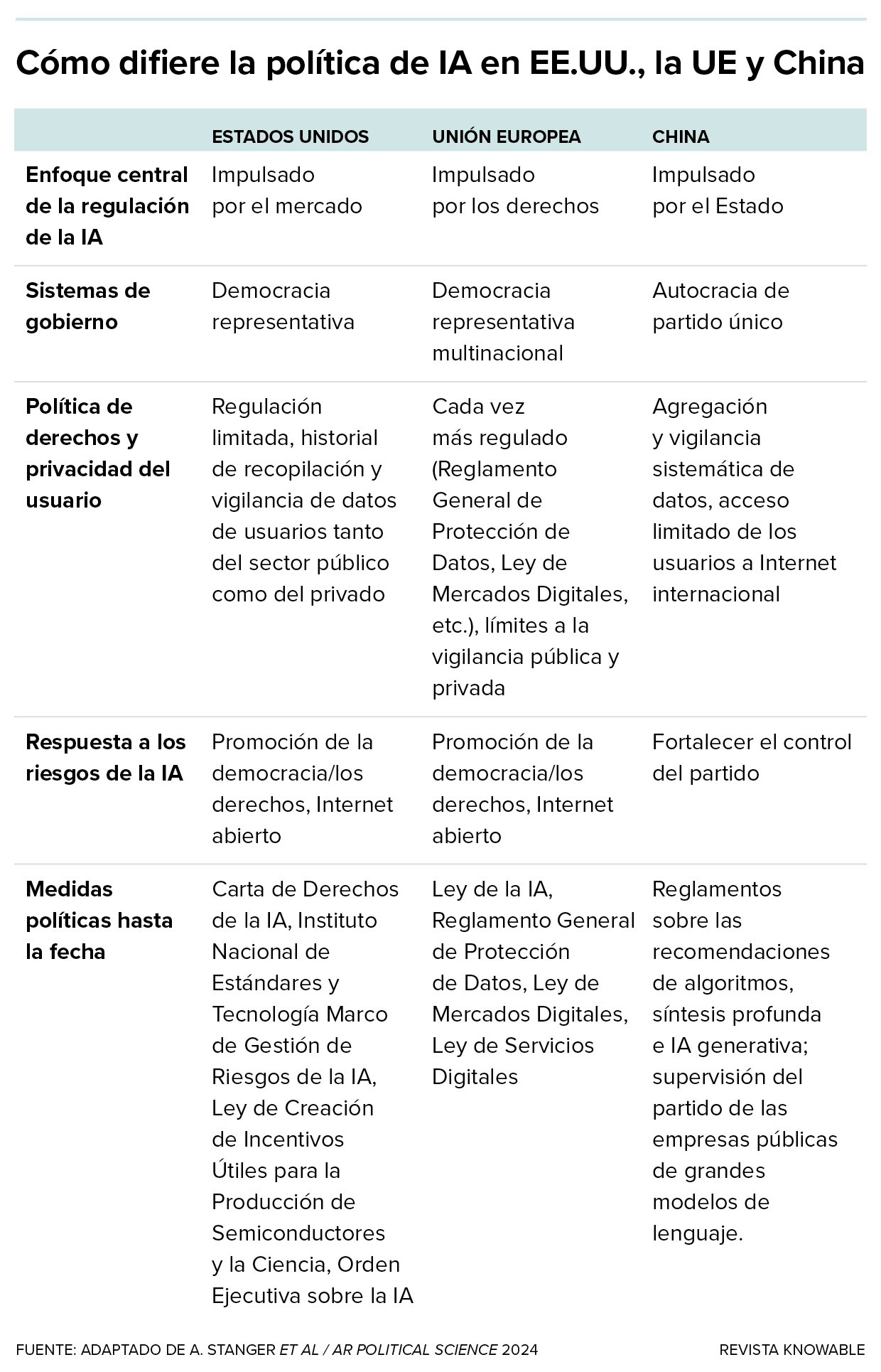

Ante la necesidad de mitigar el riesgo de la IA, los países y las regiones están trazando caminos diferentes. La Unión Europea está a la cabeza con un marco global centrado en proteger los derechos individuales y garantizar la responsabilidad de los creadores de IA, mientras que China da prioridad al control estatal a expensas de las libertades personales. Estados Unidos se esfuerza por ponerse al día en la búsqueda de un equilibrio entre la innovación y la necesidad de abordar las cuestiones éticas y de seguridad.

Estas variadas estrategias ponen de manifiesto el reto que supone regular la IA: navegar entre prioridades contrapuestas al tiempo que se aborda su impacto de largo alcance. Tanto a escala nacional como internacional, ¿podemos encontrar un terreno común para gestionar la IA de forma responsable y garantizar que sirva a los intereses de la humanidad?

Una experta en la vanguardia de ese debate es la politóloga Allison Stanger, del Middlebury College. Además de su cátedra en Vermont, Stanger es profesora asociada del Berkman Klein Center for Internet & Society de la Universidad de Harvard y autora de varios libros, entre ellos Who Elected Big Tech?

En un artículo publicado en el Annual Review of Political Science de 2024, Stanger y sus coautores exploran el panorama mundial de la gobernanza de la IA, destacando los retos que plantea y su potencial amenaza para los sistemas democráticos.

Knowable Magazine habló con Stanger sobre cómo puede regularse la IA a nivel nacional para servir a los valores democráticos y cómo podemos establecer un marco global que aborde los retos comunes. Esta entrevista ha sido editada para lograr mayor claridad.

¿Cómo caracterizaría las amenazas de la IA?

Hay dos maneras de verlo. Existe lo que a mí me gusta denominar amenazas a la democracia, en las que la inteligencia artificial agrava los problemas existentes, como los problemas de privacidad, la volatilidad de los mercados y la desinformación. Y luego están las amenazas existenciales para la humanidad, como la IA desalineada [IA que no se comporta en consonancia con los objetivos y valores humanos previstos], la guerra con drones o la proliferación de armas químicas y biológicas.

Un argumento común es que los humanos siempre han estado preocupados por las nuevas tecnologías, y la IA es solo el desarrollo más reciente. ¿En qué se diferencia la IA?

Creo que es una respuesta válida para la mayor parte de la historia de la humanidad: la tecnología cambia, la humanidad se adapta y se alcanza un nuevo equilibrio. Pero lo que hace diferente a esta innovación tecnológica en particular es que sus creadores no la entienden del todo. Si pensamos en otros avances tecnológicos, como el automóvil, puede que yo no sepa arreglar mi vehículo, pero hay alguien que sí. Lo que ocurre con la IA generativa es que, aunque sus creadores entienden las redes neuronales y el aprendizaje profundo —los algoritmos que sustentan la IA moderna—, no pueden predecir lo que va a hacer un modelo.

Eso significa que, si algo va terriblemente mal, no pueden saber inmediatamente cómo arreglarlo. Es este elemento de conocimiento el que nos lleva más allá de las capacidades humanas ordinarias para pensar y comprender. En ese sentido, es realmente como inteligencia extraterrestre.

¿Cómo podría la IA empeorar la guerra con drones y la proliferación de armas químicas y biológicas?

Las amenazas existenciales para la humanidad no significan necesariamente robots asesinos: pueden ser sistemas de IA que se desbocan, que hacen cosas para las que no fueron diseñados o que no se preveía que pudieran o fueran a hacer. Las amenazas existenciales surgirán si la IA alcanza un umbral en el que se confíe en ella para tomar decisiones sin intervención humana.

Los drones son un buen ejemplo. Se podría pensar que, de acuerdo, los pilotos de combate se queden en casa; dejamos que las computadoras luchen contra las computadoras, y todos ganan. Pero siempre hay daños colaterales en este tipo de guerra, y cuanta más autonomía tengan estos sistemas, mayor será el peligro.

Y luego está el riesgo de que la IA se utilice para crear armas biológicas o químicas. La cuestión básica es cómo evitar que la tecnología sea utilizada indebidamente por agentes malintencionados. Lo mismo ocurre con los ciberataques, en los que un solo pirata informático podría aprovechar modelos de IA de código abierto —es decir, modelos que están a disposición del público y pueden personalizarse y ejecutarse desde una computadora portátil— para irrumpir en todo tipo de sistemas.

¿Y cómo exacerba la IA amenazas más inminentes para la democracia, como la desinformación y la volatilidad de los mercados?

“Las amenazas existenciales surgirán si la IA alcanza un umbral en el que se confíe en ella para tomar decisiones sin intervención humana”.

— ALLISON STANGER

Ya sin IA, el actual sistema de redes sociales es fundamentalmente incompatible con la democracia. Para debatir los próximos pasos políticos, se necesita un núcleo de personas que crean que las mismas cosas son ciertas, y eso ha saltado por los aires debido a los algoritmos de recomendación que generan transmisiones virales de odio, desinformación y propaganda. La IA solo automatiza todas esas cosas y facilita la amplificación y distorsión del discurso humano. La automatización es también lo que podría traer una mayor volatilidad a los mercados financieros, ya que ahora tenemos todos estos modelos informáticos automatizados de IA para las transacciones financieras en las que las cosas suceden rápidamente sin intervención humana.

La IA también supone una amenaza muy real para la autonomía individual. La mejor forma en que puedo describirlo es que, si alguna vez te han facturado algo incorrectamente, es casi imposible que te atienda un humano por teléfono. En lugar de eso, tienes que pasar por todos esos robots que te hacen preguntas y dan vueltas en círculos, sin que te atiendan directamente. Así es como caracterizaría la verdadera amenaza insidiosa de la IA: si la gente confía cada vez más en ella, al final todos nos quedaremos atrapados en este mundo kafkiano que nos hace sentir superpequeños e insignificantes y como si no tuviéramos derechos humanos básicos.

¿Cómo definiría la gobernanza de la IA?

Gobernanza es decidir cómo vamos a trabajar juntos, a nivel municipal, estatal, federal y mundial, para hacer frente a esta inmensa innovación tecnológica que va a transformar nuestra sociedad y nuestra política.

¿Qué legislación u otras iniciativas ha puesto en marcha Estados Unidos para protegerse de las amenazas de la IA?

La principal iniciativa ha sido la orden ejecutiva de Joe Biden sobre IA, firmada en 2023. La orden, que da instrucciones al gobierno federal sobre qué priorizar y cómo configurar la política, se centra en garantizar que la IA sea segura y ética estableciendo normas para las pruebas, protegiendo la privacidad y abordando los riesgos para la seguridad nacional, al tiempo que fomenta la innovación y la colaboración internacional. Esencialmente, esboza barandillas que sostienen la democracia en lugar de socavarla. El presidente Donald Trump ya ha revocado esta orden.

La administración Biden también creó el Instituto de Seguridad de la IA, que se centra en el avance de la ciencia y las prácticas de seguridad de la IA, abordando los riesgos para la seguridad nacional, la seguridad pública y los derechos individuales. No está claro cuál será el destino de ese instituto bajo la administración Trump.

¿Qué leyes nacionales considera más importantes para frenar la IA?

Tenemos que dejar muy claro que los humanos tienen derechos, pero los algoritmos no. El debate nacional sobre la libertad de expresión en las plataformas en línea está actualmente distorsionado y confuso. La Corte Suprema de EE.UU. parece haber creído que las plataformas de redes sociales son solo portadoras de información; solo transmiten cosas que la gente publica de alguna manera cronológica. Sin embargo, la reciente decisión unánime de mantener la prohibición de TikTok sugiere que su interpretación es cada vez más precisa.

Todo lo que se ve en Internet está mediado por un algoritmo diseñado específicamente para optimizar el compromiso, y resulta que los seres humanos se comprometen más cuando están enfadados. Y tenemos que responsabilizar a la empresa que diseñó ese algoritmo de cualquier daño causado. Las empresas tienen derecho a la libertad de expresión. Pero una empresa es un conjunto de seres humanos. Y eso es diferente de una máquina, que es un instrumento de los seres humanos.

¿Ha avanzado Estados Unidos en este sentido?

En Estados Unidos hemos presentado una ley para derogar la Sección 230 que, simplificando, es un escudo de responsabilidad que dice que las plataformas no son editores y, por tanto, no son responsables de nada de lo que ocurra en ellas. No hay ninguna otra empresa en Estados Unidos, aparte de las empresas tecnológicas, que tenga este escudo de responsabilidad.

“Las empresas tienen derecho a la libertad de expresión. Pero una empresa es un conjunto de seres humanos. Y eso es diferente de una máquina, que es un instrumento de los humanos”.

— ALLISON STANGER

Al contar con ese escudo, los tribunales no han tenido que ocuparse de ninguna de estas cuestiones ni de cómo afectan a la democracia constitucional estadounidense. Si se aprueba la legislación propuesta, el artículo 230 quedará derogado a finales de 2025, lo que permitirá que la jurisprudencia de la Primera Enmienda se desarrolle para nuestra plaza pública virtual y que las plataformas sean responsables como cualquier otra empresa.

Más allá de la orden ejecutiva de Biden, ¿hay alguna propuesta legislativa sobre IA en EE.UU.?

Hay mucha legislación ya redactada para la seguridad de la IA. Está la Ley de responsabilidad algorítmica, que exige a las empresas evaluar el impacto de los sistemas automatizados para garantizar que no crean resultados discriminatorios o sesgados; está la Ley de responsabilidad DEEPFAKES, que pretende regular el uso de la IA para crear contenido deepfake engañoso o perjudicial; y está la Ley de innovación del futuro de la inteligencia artificial, que fomenta el estudio del impacto de la IA en la economía, la mano de obra y la seguridad nacional. Solo nos queda trabajar para que todas estas propuestas legislativas se hagan realidad.

Pero ahora mismo no nos estamos centrando lo suficiente en eso. Estados Unidos es la sede de las grandes empresas tecnológicas, y lo que hace Estados Unidos es importante para el mundo. Pero la IA no fue objeto de debate durante la campaña electoral. Tampoco estamos teniendo el debate público necesario para que los políticos hagan algo ante la ausencia total de barandillas. Europa ha sido pionera en la gobernanza de la IA, y hay mucho que podemos aprender de la UE.

¿Qué tipo de normativa ha establecido la Unión Europea?

Está la Ley de inteligencia artificial de la UE, que clasifica los sistemas de IA en niveles de riesgo (inaceptable, alto, limitado, mínimo) e impone normas más estrictas a las aplicaciones de mayor riesgo; la Ley de mercados digitales, dirigida a las grandes plataformas en línea para evitar prácticas monopolísticas; el Reglamento de servicios digitales, que obliga a las plataformas a eliminar contenidos ilegales, combatir la desinformación y ofrecer mayor transparencia sobre algoritmos y anuncios.

Por último, está el anterior GDPR —el reglamento general de protección de datos—, que da a los individuos más control sobre sus datos personales e impone requisitos a las empresas para la recopilación, procesamiento y protección de datos. El estado de California adoptó una versión del GDPR en 2018.

¿Cómo cree que podemos conseguir una gobernanza mundial de la IA? ¿Deberíamos tener tratados internacionales como los que tenemos para las armas nucleares?

Creo que deberíamos aspirar a tratados, sí, pero no van a ser como los de las armas nucleares, porque las armas nucleares son mucho más fáciles de regular. La gente corriente no tiene acceso a los componentes necesarios para construir una bomba nuclear, mientras que en el caso de la IA hay muchas cosas disponibles comercialmente.

Esta tabla contrasta las estrategias de gobernanza de la IA de Estados Unidos, la Unión Europea y China, mostrando el enfoque de Estados Unidos, impulsado por el mercado y centrado en la innovación; el énfasis de la UE, impulsado por los derechos, en la regulación y la privacidad; y el enfoque de China, impulsado por el Estado, que prioriza la vigilancia y el control del partido.

¿Cuál es la principal diferencia en la forma en que China y Estados Unidos regulan la IA?

China tiene una ética muy clara en su sistema político: es utilitarista —el mayor bien para el mayor número—. Las democracias liberales son diferentes. Protegemos los derechos individuales y no se pueden pisotear por el bien de la mayoría.

El gobierno chino ejerce un control más estricto sobre las empresas que construyen allí sistemas de IA. Por ejemplo, en 2023 China aprobó sus “Medidas para la gestión de servicios de IA generativa”, que exigen a los proveedores que garanticen que el contenido generado por IA se ajusta a los valores socialistas fundamentales del gobierno. Los proveedores deben evitar contenidos que puedan socavar la unidad nacional o la estabilidad social y son responsables de la legalidad de sus datos de entrenamiento y de los resultados generados.

Como existe una relación simbiótica entre las empresas y el Estado, la vigilancia gubernamental no es un problema: si una empresa obtiene tus datos personales, el Partido Comunista también los obtendrá. Así que China tiene una gran gobernanza de la IA —una gran seguridad de la IA—, pero sus ciudadanos no son libres. No creo que el mundo libre deba estar dispuesto a hacer este tipo de concesiones.

¿Cómo afecta esta diferencia entre sistemas autoritarios y democráticos a la gobernanza internacional de la IA?

Lo que he propuesto es un enfoque de doble vía, en el que colaboremos con nuestros aliados para mantener vivas la libertad y la democracia, al tiempo que trabajamos para reducir el riesgo de guerra con las no democracias. Todavía hay cosas que podemos acordar con países como China. Por ejemplo, podríamos llegar a un acuerdo sobre el no primer uso de armas cibernéticas en infraestructuras críticas.

Se podría decir: “Bueno, la gente lo hará sola”. Pero el funcionamiento de estos acuerdos es que el mero hecho de hablar de ello y reconocerlo como un problema crea canales de comunicación que pueden resultar muy útiles en una situación de crisis.

Por último, ¿cómo cree que afectará a la regulación de la IA la división política en Estados Unidos, donde los republicanos tienden a apoyar un enfoque de no intervención en los negocios?

Hay verdaderos creyentes en los enfoques laissez-faire del mercado, y los republicanos ven a menudo al gobierno como un torpe administrador de regulaciones. Y hay algo de verdad en ello. Pero eso plantea la cuestión de quién va a poner barreras si no es el gobierno. No van a ser las empresas, ese no es su trabajo. Es tarea del gobierno velar por el bien común y asegurarse de que las empresas no sobrepasen ciertos límites y perjudiquen a la gente.

Los europeos lo entienden instintivamente, pero los estadounidenses a veces no, a pesar de que a menudo se benefician de la protección gubernamental para garantizar la seguridad pública. Mi esperanza es que podamos convencerlos sin tener que esperar a que una catástrofe a gran escala les enseñe a través de la experiencia.

Artículo traducido por Debbie Ponchner

10.1146/knowable-022725-1

Apoye a la revista Knowable

Ayúdenos a hacer que el conocimiento científico sea accesible para todos

DONAREXPLORE MÁS | Lea artículos científicos relacionados